Arzt und Maschine

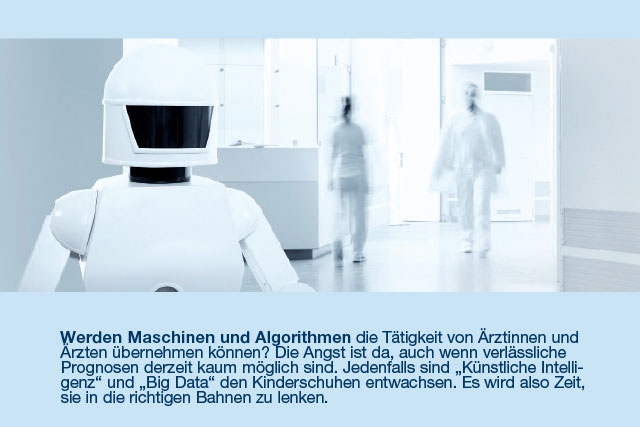

Werden Maschinen und Algorithmen die Tätigkeit von Ärztinnen und Ärzten übernehmen können? Die Angst ist da, auch wenn verlässliche Prognosen derzeit kaum möglich sind. Jedenfalls sind „Künstliche Intelligenz“ und „Big Data“ den Kinderschuhen entwachsen. Es wird also Zeit, sie in die richtigen Bahnen zu lenken.

Martin Novak

Deutschland hat die größten Chancen, die Fußballweltmeisterschaft 2018 zu gewinnen. Was nach dem frühen Ausscheiden des deutschen Teams eher absurd klingt, ist eine streng wissenschaftliche Aussage. Auf Grundlage umfangreicher wirtschaftlicher und sportspezifischer Daten kamen Statistiker bzw. Mathematiker zu diesem Ergebnis. Damit wird das ganze Dilemma Big Data-getriebener wissenschaftlicher Prognostik erkennbar. Auf den ersten Blick ist die Vorhersage grob falsch – Big Data funktioniert nicht. Auf den zweiten Blick haben die Autoren nur die Wahrscheinlichkeit berechnet und gleichzeitig eingeräumt, dass Deutschland aufgrund der Auslosung schlechtere Chancen als andere Teams hat, erfolgreich aus der Gruppenphase hervorzugehen. Und sagten den Aufstieg von 14 Teams richtig voraus – bei 16 Teams, die in die K.o.-Phase kamen, eine statistisch durchaus beeindruckende Erfolgsquote von 87,5 Prozent. Deutschland und Polen, deren Weiterkommen entgegen dem Turnierverlauf aber auch vorhergesagt wurde, wird die Statistik jedoch kaum trösten. Genauso wenig wie einen Patienten, wenn ihm ein virtuelles System eine Diagnose oder einen Behandlungsvorschlag liefert, der zwar in vielen Fällen richtig, aber in seinem falsch ist.

Natürlich kann sich auch ein Mensch im Einzelfall irren, aber mit dem kann man verhandeln, man kann Fragen stellen und seinem Unbehagen Ausdruck verleihen. Der irrenden Maschine fühlt man sich als Patient aber ausgeliefert. Es gibt keine Diskussion mit einem Algorithmus.

Dieser Algorithmus bzw. diejenigen, die hinter ihm stehen, haben aber starke Argumente auf ihrer Seite: Die Zahl der Berichte über die hohe maschinelle Diagnose- und Behandlungsqualität bei unterschiedlichen Krankheitsbildern häuft sich, der Sieg von „Big Data“ und „Deep Learning“ scheint unaufhaltsam. Zwar gibt es nicht nur Erfolgsgeschichten, sondern auch Berichte über das gloriose Scheitern „unmenschlicher“ Medizin. Nur sind die geschäftsschädigend – und werden von den Proponenten künstlicher Intelligenz (nicht nur) im Medizinbereich eher diskret behandelt.

Big Business

Und es sind große Geschäfte, die zu schädigen wären. Ganz grundsätzlich kann künstliche Intelligenz (KI) das jährliche Wirtschaftswachstum in einigen Ländern, zu denen auch Österreich gehört, verdoppeln – so eine Prognose des Strategieberatungsunternehmens Accenture. Im Medizinbereich wird KI, das geht ebenfalls aus einer Accenture-Prognose hervor, schon 2026 zu jährlichen Einsparungen von 150 Milliarden Euro führen. Die jährliche Wachstumsrate des KI-Startup-Gesundheitsmarkts beträgt von 2014 bis 2021 40 Prozent. Das bedeutet eine Verelffachung von rund 500 Millionen auf 5,65 Milliarden Euro. Die größten Brocken sind robotergestützte Operationen, virtuelle Pflegeassistenz und die Unterstützung des administrativen Workflows. Dahinter kommen aber schon Betrugserkennung, die Erkennung von Dosierungsfehlern und – Diagnostik.

Häme über gelegentliches Versagen künstlicher Intelligenz ist aber genauso wenig angebracht, wie deren Erfolg nur auf den wirtschaftlichen Hype zurückzuführen, den KI ausgelöst hat. „Künstliche Intelligenz erlebt gerade ihren Kitty-Hawk-Moment“, schreibt der Wissenschaftsjournalist Thomas Ramge (Brand eins, Economist) in seinem kürzlich erschienenen Buch „ Mensch und Maschine “. Kitty-Hawk-Moment – das ist der Augenblick, in dem die Brüder Wright erstmals mit einem Motorflugzeug vom Boden abhoben und langjährige Misserfolge vieler Vorgänger hinter bzw. unter sich ließen. So wie dieses Flugzeug namens Kitty Hawk abhob, hebt auch die „Künstliche Intelligenz“ ab. „Bei aller nötigen Vorsicht lässt sich heute sagen: In den letzten Jahren hat die Künstliche Intelligenz-Forschung Nüsse geknackt, an denen sie sich seit Jahrzehnten die Zähne ausgebissen hat“, schreibt Ramge, „mit Künstlicher Intelligenz treffen jetzt Maschinen komplexe Entscheidungen, die bisher nur Menschen treffen konnten“ und entscheiden „besser, schneller und billiger als LKW-Fahrer, Sachbearbeiter, Verkäufer, Ärzte, Investmentbanker oder Personal-Manager“. Besonders rasant, so Ramge, wachse das Angebot künstlicher Rechtsberatung, weil die Juristerei sich mit ihren präzise formulierten Regeln und der formalisierten Sprache besonders gut für Automatisierung mithilfe künstlicher Intelligenz eigne.

Hilfe oder Ersatz?

Die spannende oder auch bedrängende Frage ist, ob KI-Systeme Expertinnen und Experten ersetzen oder ihnen ein „augmented decision making“ erlauben – die menschliche Entscheidung also verbessern. Dazu gibt es zahlreiche Prognosen, optimistische und düstere. Thomas Ramge warnt allerdings davor, ihnen allzu viel Glauben zu schenken: „Wir können schlicht nicht abschätzen, wie gut die nächsten Generationen von KI-Systemen welche Aufgaben übernehmen und mit welcher Dynamik sie sich ausbreiten.“

Vielleicht, so könnte man etwas zynisch anmerken, ist die „Künstliche Intelligenz“ noch nicht so weit, um verlässliche Prognosen zu liefern – die „natürliche“, menschliche schafft es jedenfalls nicht.

Dass „Deep Learning“ (Maschinen bekommen die Regeln einprogrammiert und lernen dann auf Grundlage eigener oder fremder Erfahrungen mehr oder minder eigenständig) und „Big Data“ (Maschinen grasen alle verfügbaren Datenbanken ab und entscheiden dann auf Basis statistischer Wahrscheinlichkeiten) eine Vielzahl ethischer Fragen aufwerfen, ist aber jedenfalls gewiss. Es wäre schön, wenn die schlichten Robotergesetze aus der 1942 veröffentlichten Kurzgeschichte „ Runaround “ des berühmten Science-Fiction-Autors Isaac Asimov ausreichen würden: 1. Ein Roboter darf kein menschliches Wesen (wissentlich) verletzen oder durch Untätigkeit (wissentlich) zulassen, dass einem menschlichen Wesen Schaden zugefügt wird. 2. Ein Roboter muss den ihm von einem Menschen gegebenen Befehlen gehorchen – es sei denn, ein solcher Befehl würde mit Regel eins kollidieren. 3. Ein Roboter muss seine Existenz beschützen, solange dieser Schutz nicht mit Regel eins oder zwei kollidiert.

Die Philosophin Janina Loh , die sich mit Roboterethik befasst, beschreibt anhand eines anschaulichen Beispiels aus dem Bereich des autonomen Fahrens, wie schnell Konflikte entstehen können: „Stellen wir uns einige Kinder vor, die unerwartet auf die Straße und direkt vor ein autonomes Auto springen. Das autonome Fahrassistenzsystem berechnet nun, dass es nicht mehr rechtzeitig wird bremsen können. Es könnte hingegen sowohl in den Gegenverkehr lenken als auch in die andere Richtung, in der sich hinter einem Brückengeländer ein Abhang auftut. Während das Auto im Rahmen der ersten Option (die Spur halten und bremsen) mit hoher Wahrscheinlichkeit die Kinder überfahren oder sie schwer verletzen würde, verlöre im Rahmen der zweiten und dritten Option (Gegenverkehr und Abhang) mindestens der/die FahrerIn das Leben. Szenarien dieser Art thematisieren eine Entscheidung von großer moralischer Relevanz, für die es keine eindeutige, keine korrekte, Antwort bzw. Lösung gibt.“

Wenn es also keine ideale, sondern nur die bestmögliche Entscheidung gibt, wäre es wichtig, die Entscheidungsgrundlagen zu kennen: Zählt das Leben von Kindern mehr als das von Erwachsenen? Geht es (in der Medizin) nur darum, Leben zu retten oder auch darum, Leiden zu mildern oder Kosten zu sparen? Und wie sind diese Grundlagen gewichtet? „Wenn die Maschine eine bestimmte Chemotherapie bei einem bestimmten Patienten empfiehlt, darf sie ihren Ratschlag nicht einfach ausspucken wie ein allwissendes Orakel. Sie muss dem behandelnden Arzt gegenüber begründen, wie es zu diesem Ergebnis als bester Lösung des Problems gekommen ist“, meint Ramge. Allerdings sei auch das nicht so einfach: „Die Maschine weiß mehr, als sie dem Menschen erklären kann.“

Große Daten

Der deutsche Ethikrat hat im Jahr 2017 eine 300 Seiten umfassende Stellungnahme zu „Big Data und Gesundheit“ veröffentlicht. Vorweg wies das Expertengremium darauf hin, dass die Nutzung von Daten kein neues Phänomen sei: „Die systematische Erhebung und Auswertung von Daten ist spätestens seit Beginn der Neuzeit ein bedeutender Faktor zivilisatorischer Entwicklung und schließt auch den Menschen und seine Lebensumgebung ein …“

Allerdings ergäben die aktuellen und zu erwartenden technischen Entwicklungen völlig neue Möglichkeiten, die Daten zu verwenden, die „besonders sensibel“ seien, „weil sie tiefe Einblicke in einen sehr intimen Bereich ermöglichen“: „Personenbezogene Daten können aus einer immer größeren Zahl von Quellen gesammelt und miteinander verknüpft werden, wobei im Verlauf des Auswertungsprozesses auch solche Daten Gesundheitsrelevanz erlangen können, die einen entsprechenden Anschein zunächst nicht erwecken, zum Beispiel Bewegungsdaten oder Einkaufsdaten. (…) Weil alle Daten, die in irgendeiner Form erhoben werden, in Relation zur persönlichen Gesundheit interpretiert werden können, ist es prinzipiell möglich, all diese Daten auch als gesundheitsrelevant einzuschätzen.“

Alter Datenschutz

Mit dem geltenden Datenschutzrecht, so der Ethikrat, könne über kurz oder lang nicht mehr das Auslangen gefunden werden, weil derzeit der Schutz spezieller Daten im Vordergrund stünde und weniger der Schutz der „Datengeber“. Die geben scheinbar harmlose Daten recht bereitwillig heraus, ohne zu ahnen, dass diese (in Verknüpfung mit anderen) schon in näherer Zukunft brisante Rückschlüsse auf die Gesundheit erlauben.

Fazit des Ethikrats: „Unter den Bedingungen von Big Data ist es notwendig, sich von überholten Vorstellungen einer spezifischen, vorgegebenen Sensibilität bestimmter Daten und hierauf rekurrierender besonderer Schutzmechanismen zu lösen. Datenschutz kann nicht mehr statisch an bestimmten Daten und Datennutzungskategorien ansetzen, sondern muss sich auf ständige Rekombinationen und Rekontextualisierungen einstellen.“ Seine Empfehlung: „ein Gestaltungs- und Regelungskonzept, das sich am zentralen Ziel der Datensouveränität orientiert“.

Alles anders

„Wir werden uns völlig neu orientieren müssen“, sagt auch Dietmar Bayer, Referent für Telemedizin und medizinische Informatik der Österreichischen Ärztekammer. Noch sei die Medizin real „im Stadium der digitalen Transformation“. In der Regel seien die Systeme „dumm“, würden die gängige ärztliche Tätigkeit zwar digitalisieren, aber nicht substanziell verändern, unterstützen oder gar ersetzen – noch. Denn „Künstliche Intelligenz“ und „Big Data“ hätten genau diese Fähigkeiten. Dann – und dann heißt: in Kürze – müsse man von „ Disruptive Medicine“ sprechen: „Disruptive Medicine“, prognostiziert Bayer, „wird uns aus der Medizin, wie wir sie bisher betrieben haben, schmerzlich herauskatapultieren.“ Ärztinnen und Ärzte würden sich dann mit Dingen befassen müssen, die sie nicht gelernt haben.

Wenn Ärztinnen und Ärzte mit den Patientinnen und Patienten nicht zu den Opfern der Veränderung werden sollen, müssten sie „die Regeln aufstellen und die Algorithmen bestimmen“, so Bayer. Für den nächsten Kammertag der Österreichischen Ärztekammer im Dezember ist ein massiver Schwerpunkt „Digitalisierung“ geplant.

Ziel ist es, den Wildwuchs – getrieben von der nahezu unübersehbaren Zahl der Hersteller von Gesundheits-Apps und von großen IT-Unternehmen – so zu beschneiden, dass medizinische Qualität und ärztliche Kompetenz maßgeblich bleiben.

Die ÖÄK ist mit den Systempartnern auf vielen Ebenen im Gespräch und bemüht sich darum, die vielen Einzelaktionen zu fokussieren. Der Schwerpunkt liegt dabei auf Projekten mit echtem Mehrwert.

Der Vollständigkeit halber: Frankreichs Chancen, die Fußball-WM zu gewinnen, stufte die Studie recht gut ein – nur schlechter als die von Deutschland, Brasilien und Spanien. Die Wahrscheinlichkeit für den zweiten Finalisten Kroatien dagegen war laut Untersuchung ziemlich bescheiden.

Der zweidimensionale Arzt

Arzt und Patient, die einander nur vom Telefon, vom E-Mail oder – bestenfalls – vom Monitor kennen, wenn es die Leistungsfähigkeit der Datenleitung zulässt …

Für viele ist das eine Schreckensvision. Und es gibt gute Argumente gegen die reine Fernbehandlung: Wichtige Dimensionen der Kommunikation und Zwischentöne gehen verloren. Wer schon einmal geskypt hat, weiß das. Die zweidimensionale Kommunikation ist nur ein schwacher Abklatsch des persönlichen Kontakts.

Aber: WhatsApp und andere Messaging-Dienste, E-Mail, Skype & Co. werden für immer mehr Menschen – nicht nur ganz junge – immer normaler. Und selbst für jene, die diese Entwicklung kritisch sehen, ist die Kommunikation mit technischen Hilfsmitteln besser als gar keine.

Und: Diese flache Kommunikation hat auch Vorteile: Niemand muss bei Kälte oder Hitze, bei Regen oder Sturm seine sicheren Räume verlassen. Zeitintensive Anreisen werden überflüssig. So ist es auch nicht verwunderlich, dass immer mehr Anbieter die technikgestützte ärztliche Beratung und Behandlung anbieten. Für sie ist diese Form der Telemedizin gleichsam eine Goldmine.

Die deutsche Bundesärztekammer hat (wie berichtet) kürzlich auch Grünes Licht für reine Video- und Online-Konsultationen gegeben, wohl auch aus Besorgnis darüber, dass telemedizinische Großanbieter, die sich nicht an die ärztlichen Regeln gebunden fühlen, den deutschen Markt überschwemmen.

Darum geht es: Marktüberlegungen und Shareholder Value sollen und dürfen nicht medizinische Qualität und ärztliches Ethos unterhöhlen. Nicht in Deutschland und auch nicht in Österreich.

AERZTE Steiermark Juli-August 2018

Illus: Fotolia, Foto: Schiffer